Yüksek boyutlu bilgiler, çeşitli tahliller ve yapay zeka uygulamalarından faydalanılarak tasarlanan makine öğrenme algoritmaları, insan zihninin ötesinde bir öğrenme tecrübesi sunuyor. Lakin bu algoritmalarda kullanılan yapay zeka eğitimleri, beşerler tarafından seçilen ve derlenen bilgilerle yapıldığı için büyük sorunları de beraberinde getiriyor.

Ön yargı hayatımızın bir kesimi olsa da bunun yapay zeka algoritmalarına yansıması gelecekte büyük sorunların oluşmasına sebep olabilir. Cinsiyetlerden ırklara kadar birçok ön yargı, daha evvel geliştirilen birtakım yapay zeka uygulamalarından karşımıza çıkan en büyük sorunlardan biri.

The Agile Architecture Revolution isimli kitabın yazarı Jason Bloomberg, yapay zekanın uygulamalarında karşılaşılan ön yargı sorununun gelecek ismine büyük bir tehdit olduğunu söylüyor. Yapay zekanın eğitim bilgileri hakkında konuşan Bloomberg, “İnsanlar hakkındaki bilgi kümeleri, fiziksel dünyayla ilgili datalara daha az hassasken ön yargılara karşı daha duyarlı” tabirleriyle yapay zeka uygulamalarında ön yargının ne kadar büyük bir sorun olduğunu belirtiyor. Geçmişte ön yargı meselesiyle karşılaşılan birkaç yapay zeka örneğine gelin birlikte göz atalım.

Microsoft'un ırkçı yapay zekası Tay.AI:

Microsoft tarafından 2016 yılında geliştirilen Twitter sohbet botu Tay.AI, 'TayandYou' isimli Twitter hesabından beşerlerle etkileşime girmiş ve inanılmaz karşılıklar vererek tüm dünyayı şaşkına çevirmişti. Verdiği ırkçı, cinsiyetçi ve küfürlü yanıtlarla başlangıcından tam 16 saat sonlandırılan proje, o devir yapay zekada karşılaşılan ırkçılık ve cinsiyetçilik sorunlarını göz önüne sermişti.

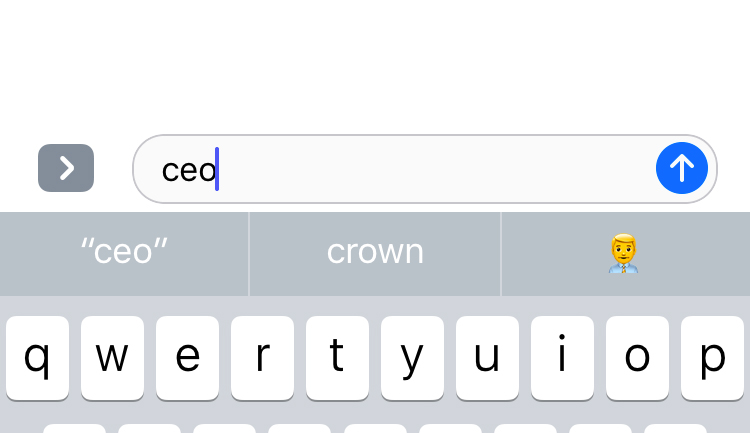

Apple'ın cinsiyetçi emoji önerme sistemi:

Geçtiğimiz yıl iPhone kullanıcıları, klavyeden 'CEO' sözünü tuşladıklarında, telefon 'iş adamı' isimli emojiyi önererek yapay zekanın cinsiyetçi bir tavır takınabileceğini bizlere göstermişti. Apple, daha sonra yayınlanan bir güncellemeyle bu sorunu çözmüş ve kullanıcılarına bu çeşit teklif durumlarında cinsiyet seçeneği sunmuştu.

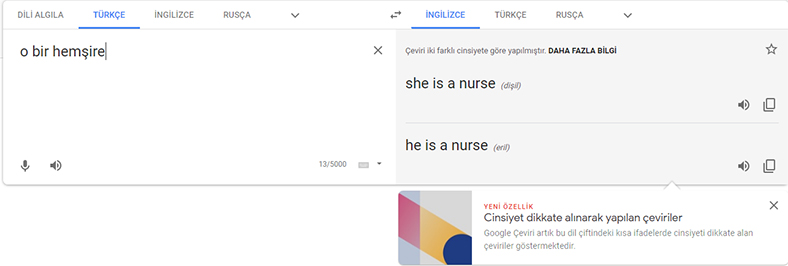

Google Translate'in cinsiyetçi çeviri sistemi:

Daha evvelki sürümlerinde 'o bir hemşire' cümlesini 'she is a nurse', 'o bir doktor' cümlesini 'he is a doctor' halinde çeviren Google Translate, bizlere yapay zekanın cinsiyetçi olabileceğini bir kere daha göstermişti. Google Translate'e gelen yeni bilhassa birlikte artık Türkçe dilinden eril ve dişil ayrımı yapılan lisanlara çevirilerde cinsiyet dikkate alınarak kullanıcılara farklı çeviri seçenekleri sunulacak.

Yapay zeka algoritmaları, tanımlanan data setlerinde belli mesleklerdeki erkeklerin sayısının daha fazla olmasını tespit eder ve buna nazaran bir sonuç verir. Bu durum da yapay zekanın eğitiminde kullanılacak veri setinin ne derece değerli olduğunu açığa çıkarıyor.

Bu noktada yapılması gereken şey, programcıların yapay zekada ortaya çıkabilecek ön yargıları evvelden tespit edip buna nazaran tedbir almaları olmalı. Ayrıyeten eğitimlerde kullanılan bilgi setlerinin, itinayla seçilmesi ve rastgele bir ön yargı oluşumuna mahal vermemesi gerekiyor.

Google Translate örneğinde olduğu üzere tahlillerin yanı sıra yapay zekayı ön yargıya karşı eğitmek de bir seçenek. Dünya üzerinde birçok programcı, yapay zekada karşılaşılan bu sorunlar üzerine çalışsa da şu an için tesirli bir prosedür şimdi uygulanabilmiş değil. Önümüzdeki süreçte yapay zekanın konut büyük sorunlarından ırkçılık ve cinsiyetçiliğe karşı tahlil bulunup bulunamayacağını daima birlikte göreceğiz.

Cevap Bırakın